Llama 3 是 Meta 最新的大型語言模型。您可以將其用於各種目的,例如解決您的疑問、獲得學校作業和項目的幫助等。在本地 Windows 11 計算機上部署 Llama 3 將幫助您隨時使用它,即使無法訪問互聯網。這篇文章向您展示如何在 Windows 11/10 PC 上本地安裝 Llama 3。

通過 Python 在 Windows 11/10 PC 上安裝 Llama 3 需要技術技能和知識。但是,一些替代方法允許您在 Windows 11 計算機上本地部署 Llama 3。我將向您展示這些方法。

要在 Windows 11 PC 上安裝並運行 Llama 3,您必須在命令提示符中執行一些命令。但是,這僅允許您使用其命令行版本。如果您想使用其 Web UI,則必須採取進一步的步驟。我將向您展示這兩種方法。

通過 CMD 在 Windows 11 PC 上部署 Llama 3

要在 Windows 11 PC 上部署 Llama 3,您需要在 Windows 計算機上安裝 Ollama。其步驟如下:

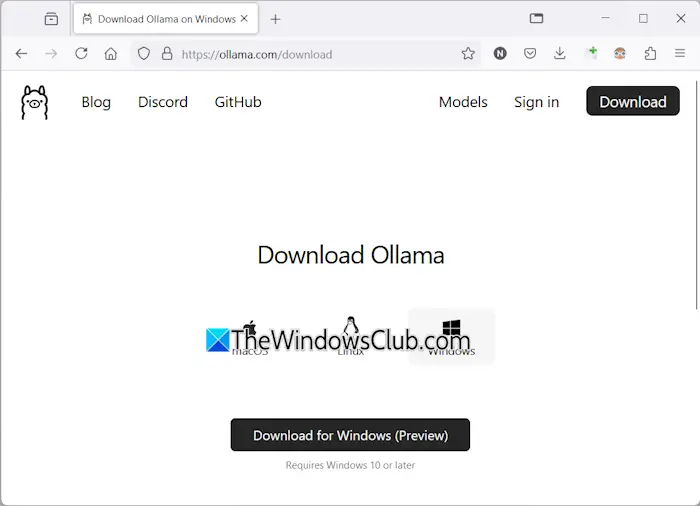

- 訪問奧拉瑪官方網站。

- 單擊下載按鈕,然後選擇視窗。

- 現在,單擊下載 Windows 版按鈕將 exe 文件保存到您的 PC 上。

- 運行 exe 文件以在您的計算機上安裝 Ollama。

在您的設備上安裝 Ollama 後,重新啟動計算機。它應該在後台運行。您可以在系統托盤中看到它。現在,單擊 Ollama 網站上的“模型”選項。您會看到它的不同型號。

Llama 3.1有以下三個參數:

- 8B

- 70B

- 405B

最後一項是最大的參數,顯然無法在低端PC上運行。 Llama 3.2有以下兩個參數:

- 1B

- 3B

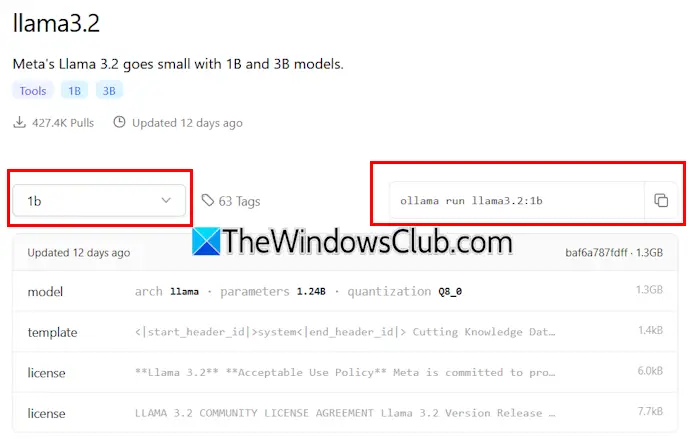

單擊您要在 PC 上安裝的 Llama 版本。例如,如果您要安裝 Llama 3.2,請單擊 Llama 3.2。在下拉列表中,您可以選擇要安裝的參數。之後,複製旁邊的命令並將其粘貼到命令提示符中。

為了您的方便,我為 Llama 3.2 模型編寫了這兩個命令。要安裝 Llama 3.2 3B 模型,請運行以下命令:

ollama run llama3.2:3b

要安裝 Llama 3.2 1B 模型,請使用以下命令:

ollama run llama3.2:1b

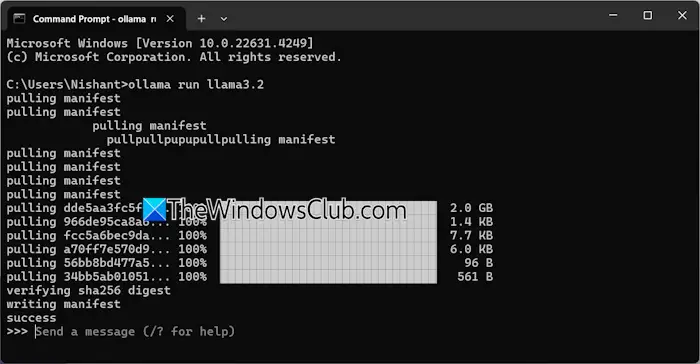

打開命令提示符,鍵入上述任何命令(根據您的要求),然後點擊進入。下載所需的文件需要一些時間。下載時間還取決於您的互聯網連接速度。完成後你會看到成功命令提示符中的消息。

現在,輸入消息以使用 Llama 3.2 模型。如果您想安裝 Llama 3.1 模型,請使用 Ollama 網站上提供的命令。

下次啟動命令提示符時,請使用相同的命令在 PC 上運行 Llama 3.1 或 3.2。

通過 CMD 安裝 Llama 3 有一個缺點。它不會保存您的聊天記錄。但是,如果您將其部署在本地主機上,您的聊天記錄將被保存,並且您將獲得更好的用戶界面。下一個方法展示瞭如何做到這一點。

在 Windows 11 上部署 Llama 3 Web UI

與在 CMD 窗口上使用相比,在 Web 瀏覽器上使用 Llama 3 可以提供更好的用戶界面,並且還可以保存聊天歷史記錄。我將向您展示如何在 Web 瀏覽器上部署 Llama 3。

要在 Web 瀏覽器中使用 Llama 3,應通過 Ollama 和 Docker 在您的系統上安裝 Llama 3。如果您尚未安裝 Llama 3,請使用 Ollama 安裝它(如上所述)。現在,從其下載並安裝 Docker官方網站。

安裝 Docker 後,啟動它並註冊創建一個帳戶。在您註冊之前,Docker 不會運行。註冊後,在 Docker 應用程序上登錄您的帳戶。將 Docker 最小化到系統托盤。 Docker 和 Ollama 應用程序應在後台運行。否則,您將無法在網絡瀏覽器中使用 Llama 3。

現在,打開命令提示符,複製以下命令,並將其粘貼到命令提示符中:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

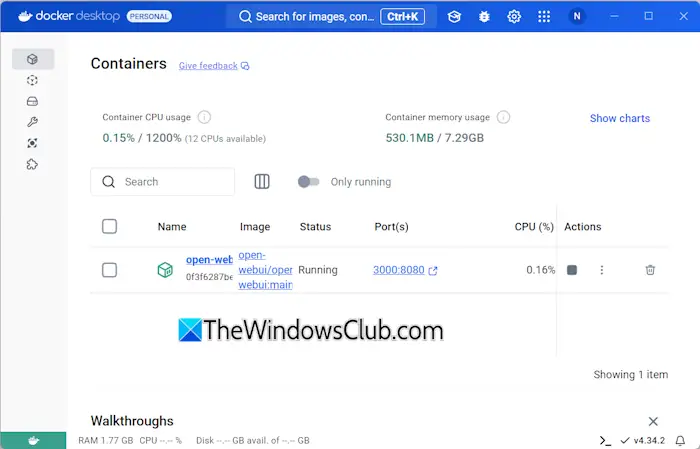

上述命令將需要一些時間來下載所需的資源。因此,要有一些耐心。命令完成後,打開Docker並選擇集裝箱從左側開始的部分。您將看到自動創建了一個容器,端口為 3000:8080。

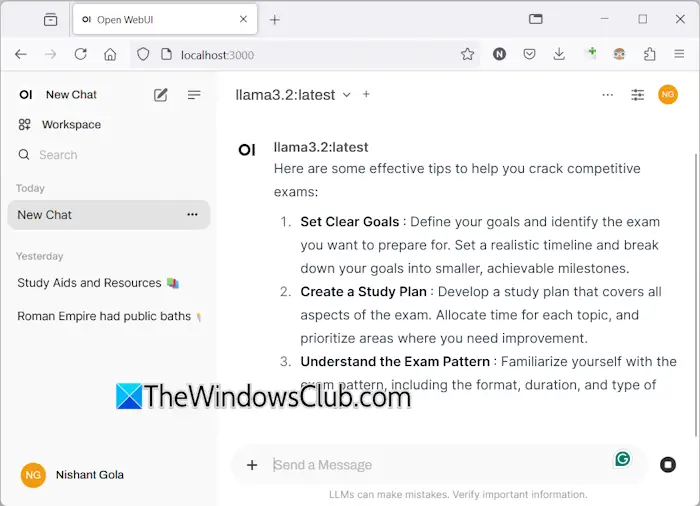

單擊端口 3000:8080。這將在您的默認網絡瀏覽器中打開一個新選項卡。現在,註冊並登錄以在網絡瀏覽器上使用 Llama 3。如果您看到地址欄,您將看到本地主機:3000那裡,這意味著 Llama 3 託管在您的計算機本地。您可以在沒有互聯網連接的情況下使用它。

從下拉列表中選擇您的 Llama 聊天模型。如果您想添加更多 Llama 3 的聊天模型,您必須使用所需的命令通過 Ollama 安裝它。之後,該模型將自動在您的網絡瀏覽器中可用。

您的所有聊天記錄都將保存並可在左側訪問。當您想退出時,請在網絡瀏覽器中註銷您的會話。之後,打開 Docker 應用程序並單擊停止按鈕來停止 Docker。現在,您可以關閉 Docker。

當您下次想在 Web 瀏覽器中使用 Llama 3 時,啟動 Ollama 和 Docker,等待幾分鐘,然後單擊 Docker 容器中的端口以在 Web 瀏覽器中打開 localhost 服務器。現在,登錄您的帳戶並開始使用 Llama 3。

我希望這有幫助。

Llama 3 可以在 Windows 上運行嗎?

根據您計算機的硬件配置,您可以在系統上運行 Llama 3。其1B型號是最輕的。您可以通過命令提示符在系統上安裝並運行它。

Llama 3 需要多少內存?

Llama 3 最輕的型號是 Llama 3.2 1B。您的系統應具有 16 GB RAM 才能運行 Llama 3.2 1B 模型。除此之外,您的系統還應該有一個重型 GPU。 Llama 3 的更高型號需要更多的系統資源。

閱讀下一篇:。

![要中斷普通啟動,請按在聯想筆記本電腦上輸入錯誤[FIX]](https://sclub.recmg.com/tech/blogs/wp-content/uploads/2025/02/To-interrupt-normal-startup-press-Enter.png)